Shadow AI, ou IA Sombra, é um termo que descreve o uso de ferramentas, sistemas ou modelos de Inteligência Artificial (IA) por funcionários de uma organização sem a aprovação, supervisão ou gerenciamento explícito dos departamentos de TI e cibersegurança. Em outras palavras, é qualquer aplicação de IA que opera "nas sombras" da estrutura de governança corporativa.

Para quem já está familiarizado com o conceito de "Shadow IT" (o uso de qualquer hardware ou software não autorizado), a lógica é a mesma. A diferença crucial é que a Shadow AI lida especificamente com soluções de inteligência artificial, que introduzem um novo universo de desafios relacionados a dados, vieses e tomada de decisão autônoma.

Na prática, a Shadow AI se manifesta de várias formas. Pode ser um analista de marketing usando uma ferramenta online de IA para analisar dados de clientes, uma equipe de RH testando um software não autorizado para triagem de currículos, ou um desenvolvedor integrando um modelo de machine learning de código aberto em um projeto sem a devida validação de segurança.

Embora muitas vezes essas iniciativas sejam feitas de boa fé para aumentar a produtividade ou inovar, elas criam brechas significativas de segurança. Por operarem fora dos frameworks de governança, essas ferramentas aumentam os riscos de vazamento de dados, violações de conformidade e abrem novos pontos de entrada para ciberataques.

A prática da Shadow AI não acontece por acaso. Ela é o resultado de uma combinação de fatores, principalmente o avanço da tecnologia e as novas formas de trabalhar, que incentivam os funcionários a resolverem problemas por conta própria.

A principal razão para o crescimento da Shadow AI é que nunca foi tão fácil ter acesso a ferramentas de Inteligência Artificial. Hoje, com tantas plataformas, frameworks e APIs disponíveis, qualquer funcionário com um pouco de conhecimento técnico consegue encontrar e usar suas próprias soluções de IA.

Serviços na nuvem e ferramentas de código aberto tornaram isso ainda mais comum. Para completar, as plataformas low-code e no-code praticamente eliminaram a barreira da programação, permitindo que equipes de marketing ou RH comecem a usar IA no seu dia a dia sem depender do time de TI.

Na maioria das vezes, a intenção do funcionário é boa. As pessoas querem produzir mais e melhor, e as ferramentas de IA surgem como a solução perfeita para automatizar tarefas repetitivas e ganhar tempo.

Essa criatividade, que vem dos próprios funcionários, é ótima para a empresa e melhora a eficiência de todos. O problema começa quando essa busca por autonomia ignora as regras de segurança da organização, e é exatamente aí que a Shadow AI aparece.

Em muitas empresas, as equipes trabalham com prazos curtos e precisam ser rápidas para competir no mercado. Se o departamento de TI é muito lento para aprovar ou oferecer novas ferramentas — seja por excesso de regras ou falta de pessoal — os funcionários acabam procurando soluções externas por conta própria.

Essa liberdade para escolher as próprias ferramentas parece boa, mas o custo é alto: a empresa perde o controle e a supervisão, o que abre portas para sérios riscos de segurança.

Apesar de geralmente nascer de boas intenções, a Shadow AI abre a porta para uma série de ameaças que podem comprometer a segurança, a reputação e a saúde financeira de uma empresa. Abaixo, detalhamos os principais riscos.

Pense na "superfície de ataque" como o total de pontos vulneráveis que um cibercriminoso pode tentar explorar em uma empresa. A Shadow AI aumenta drasticamente essa superfície ao adicionar sistemas, aplicativos e dispositivos que a equipe de TI nem sabe que existem. Afinal, é impossível proteger algo que você não conhece.

Essas ferramentas não autorizadas muitas vezes rodam em serviços de nuvem ou até mesmo em dispositivos pessoais, fora do perímetro de segurança da organização, tornando-as alvos fáceis para ataques.

Um dos maiores perigos é quando funcionários usam ferramentas de Shadow AI para analisar dados de clientes, registros financeiros ou outras informações confidenciais. Muitas vezes, sem perceber, eles podem transferir esses dados para servidores de terceiros com protocolos de segurança fracos ou inexistentes.

Isso cria um enorme risco de conformidade. O uso descontrolado de dados pode violar leis de privacidade como a Lei Geral de Proteção de Dados (LGPD) no Brasil ou a GDPR na Europa. As consequências vão desde multas pesadas até a perda da confiança dos clientes e danos irreparáveis à reputação da empresa.

Além dos riscos mais conhecidos, a Shadow AI introduz vulnerabilidades técnicas mais sofisticadas. Uma delas é o Model Poisoning (ou envenenamento de modelo).

Nesse tipo de ataque, um cibercriminoso corrompe intencionalmente os dados usados para treinar o modelo de IA. Como resultado, o modelo aprende com informações falsas e começa a tomar decisões erradas, classificar dados incorretamente ou até mesmo conceder acessos indevidos, tudo de forma silenciosa e difícil de detectar.

Outros riscos técnicos incluem:

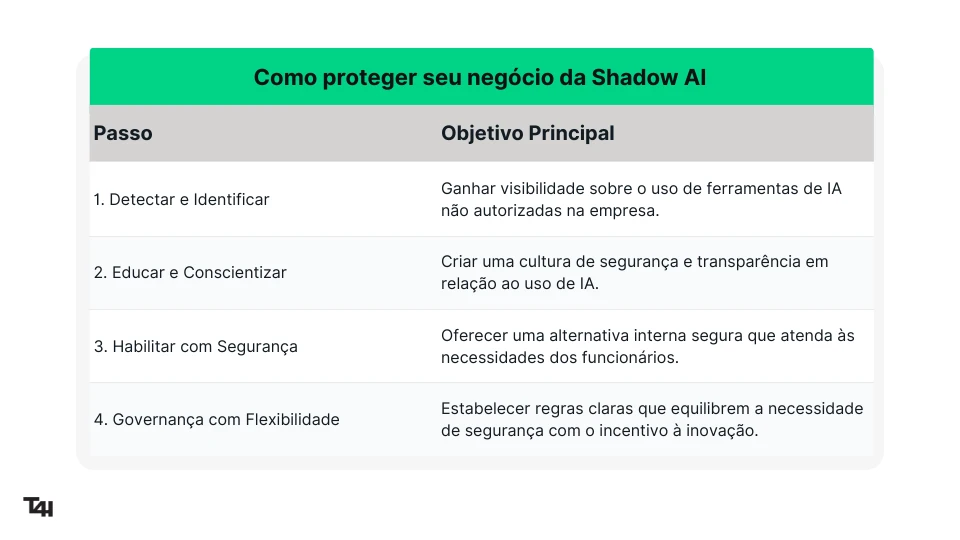

Lidar com a Shadow AI não é uma caça às bruxas. O objetivo é criar um ambiente onde a inovação possa acontecer com segurança. Em vez de simplesmente proibir, a abordagem mais inteligente é detectar, educar, habilitar e governar.

A seguir, apresentamos um guia de 4 passos para colocar isso em prática.

Você não pode gerenciar aquilo que não consegue ver.

O primeiro passo é ganhar visibilidade sobre quais ferramentas de IA estão sendo usadas na sua empresa. O objetivo aqui não é punir, mas sim entender quais são as necessidades que os funcionários estão tentando resolver por conta própria.

A tecnologia sozinha não resolve o problema. É crucial promover treinamentos regulares sobre os riscos da Shadow AI, as políticas da empresa e a importância de proteger os dados sensíveis.

Crie uma cultura de transparência, onde os funcionários se sintam seguros para conversar com a equipe de TI sobre as ferramentas que desejam usar, em vez de escondê-las.

Quando as pessoas entendem o "porquê" das regras, a chance de cumpri-las é muito maior.

A maneira mais eficaz de reduzir o uso de ferramentas externas é oferecer uma alternativa interna que seja melhor, mais útil e totalmente segura. A simples proibição raramente funciona se os funcionários não tiverem uma opção viável para realizar seu trabalho com eficiência. É aqui que entram os GPTs Corporativos Personalizados.

É exatamente isso que soluções como a da Tech for Humans proporcionam. Elas permitem que uma empresa crie seu próprio GPT Interno, que opera com total segurança por estar conectado exclusivamente às bases de conhecimento da própria organização.

Com isso, os funcionários podem fazer consultas rápidas de informações, analisar dashboards, imagens e documentos técnicos, sabendo que nenhum dado sensível está sendo enviado para fora da empresa.

Essa abordagem atende à necessidade de produtividade das equipes e, ao mesmo tempo, elimina a principal causa da Shadow AI: a busca por soluções externas.

Finalmente, é preciso desenvolver uma política de governança de IA que equilibre segurança e inovação. As regras devem ser claras, mas não tão rígidas a ponto de sufocar a criatividade. Uma excelente prática é criar um ambiente de testes controlado, conhecido como "AI Sandbox", onde os funcionários podem experimentar novas ferramentas de IA com a supervisão da equipe de TI.

Essa política deve definir o que é permitido, como os dados devem ser manuseados e qual é o processo para solicitar a aprovação de uma nova ferramenta. O objetivo é criar um caminho claro para que a inovação aconteça de forma segura e alinhada aos objetivos do negócio.

A Shadow AI é uma realidade inevitável na era da inteligência artificial. Tentar proibi-la é uma batalha perdida que sufoca a inovação que as empresas precisam. A abordagem mais inteligente não é o bloqueio, mas sim o gerenciamento estratégico para canalizar a criatividade dos funcionários de forma segura.

Ao adotar uma política de governança clara e, principalmente, ao habilitar as equipes com ferramentas internas seguras, como um GPT Corporativo, o risco se transforma em vantagem competitiva. As empresas que aprendem a gerenciar suas "sombras" são as que, de fato, vão liderar o futuro.

Na Tech for Humans (T4H), nós desenhamos e implementamos Jornadas Digitais e Agentes de IA. Como donos da nossa própria tecnologia, criamos projetos sob medida para resolver os desafios específicos do seu negócio com mais agilidade.

Grandes empresas como Porto, Allianz e MAPFRE já usam nossos Agentes de IA, substituindo seus antigos chatbots por verdadeiros copilotos inteligentes, capazes de compreender, decidir e executar. O resultado prático é mais retenção de clientes, maior eficiência e uma experiência de atendimento em um novo nível.

Quer saber como aplicar IA no seu negócio? Fale conosco.

PUTHAL, D. et al. (2025). Shadow AI: Cyber Security Implications, Opportunities and Challenges in the Unseen Frontier. SN Computer Science. Disponível em:https://doi.org/10.1007/s42979-025-03962-x.

E acesse, em primeira mão, nossos principais conteúdos diretamente do seu e-mail.